Bun venit la un nou număr din Promptescu Daily Digest!

Astăzi vorbim despre revenirea spectaculoasă a DeepSeek, care a aruncat din nou industria AI în aer cu modelele V3.2 și Speciale… primele care fac raționamentul pe contexte uriașe accesibil și, culmea, mai ieftin decât concurența occidentală. Iar pe final, facem un zoom-out ca să înțelegem unde duce toată nebunia asta și de ce următoarele 6–12 luni vor conta mai mult decât ultimii 5 ani.

Promptescu, ce s-a mai întâmplat astăzi în lumea AI?

DeepSeek a lansat două noi modele care împing înainte frontiera cercetării în inteligența artificială.

CEO-ul IBM, Arvind Krishna, a explicat că investițiile uriașe în centre de date AI nu au cum să se amortizeze la costurile actuale

Dwarkesh Patel este pesimist pe termen scurt… modelele actuale nu învață robust “la locul de muncă” și necesită pre-antrenare scumpă (RLVR), dar extrem de optimist pe termen lung

🐳 DeepSeek revine cu un nou model de AI… și pare pregătit să rescrie regulile jocului.

Tot ce trebuie să știi despre DeepSeek V3.2

DeepSeek revine în scenă și, dacă ești în industria AI din SUA, numele lor sună cam ca… Death Star. Nu pentru că ar distruge planete, ci pentru că, istoric vorbind, fiecare lansare DeepSeek a „evaporat” câteva miliarde din evaluările competitorilor.

Iar acum au făcut-o din nou: DeepSeek V3.2 și V3.2-Speciale - două modele care fac AI-ul cu context lung în sfârșit accesibil ca preț.

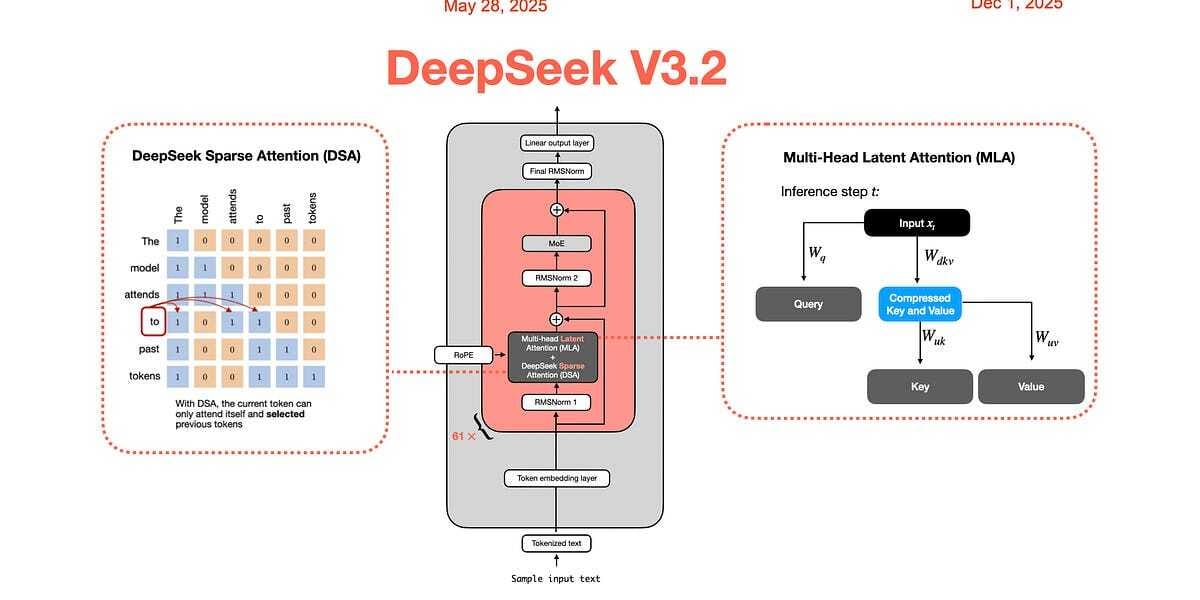

Care e inovația? Sparse Attention

Gândește-te la sparse attention ca la un sistem foarte deștept de filtrare:

modelul se concentrează doar pe ce contează, în loc să recitească mereu tot istoricul.

Modelele clasice (inclusiv ChatGPT) încetinesc drastic pe măsură ce contextul crește.

Un document de 100.000 de cuvinte costă ~100× mai mult decât unul de 10.000.

Cu abordarea DeepSeek, costul scade la ~10×.

Un salt de eficiență de 10×… pe bune.

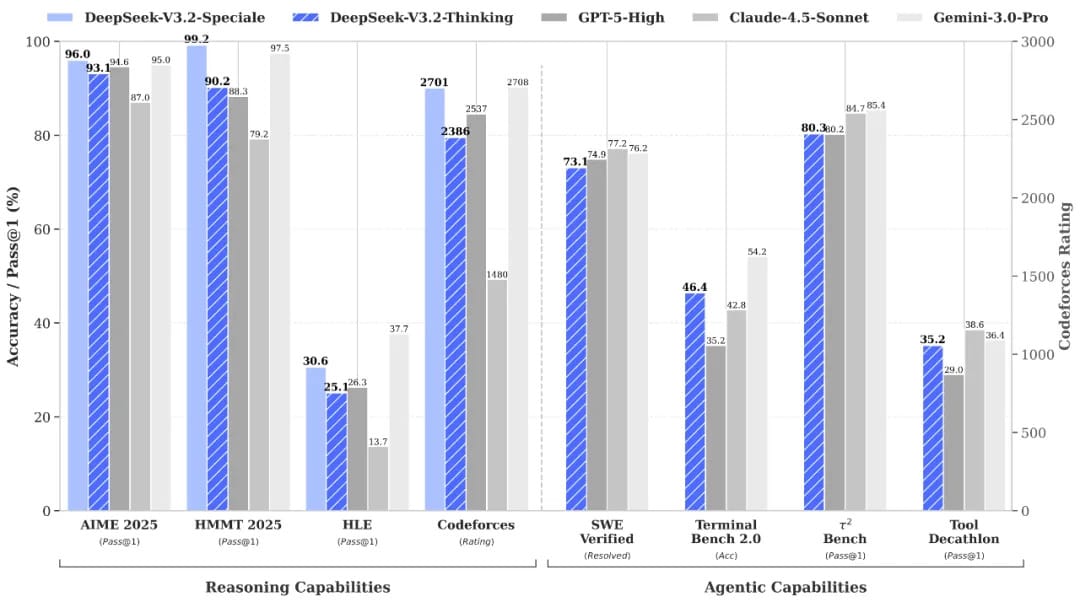

Performanță de nivel olimpic (la propriu)

V3.2-Speciale este primul model care obține medalii de aur la:

IMO 2025 (Olimpiada Internațională de Matematică)

CMO 2025

IOI 2025

ICPC World Finals

După cum a remarcat un cercetător: „Au lansat un model care ia aur la IMO înaintea Google sau OpenAI.”

La alte benchmark-uri de raționament:

AIME 2025: Speciale = 96.0%

(GPT-5 = 94.6%, Gemini 3 Pro = 95.0%)HMMT Feb 2025: 99.2% - cel mai mare scor raportat.

Există un mic dezavantaj: Speciale generează 23.000–45.000 tokeni per problemă complexă

(competiția produce 13k–18k). Dar…

Prețul schimbă ecuația:

Speciale = $0.40 / milion tokeni

GPT-5 = $10 / milion

Gemini = $12 / milion

Chiar și cu mai mulți tokeni, economisești 5–10× la costul final.

🏗️ Cum au construit DeepSeek V3.2

Au investit masiv în reinforcement learning (RL):

2.000 de pași de antrenare

1.800 de „lumi simulate” (coding, matematică, SQL etc.)

85.000 de instrucțiuni complexe

Și au folosit o strategie în două etape:

1️⃣ Un model „indexer” care decide ce părți din context sunt relevante.

2️⃣ Modelul mare trece pe mod sparse, ignorând automat balastul.

Rezultatul: raționament mai bun, costuri mai mici, context mai mare.

De ce contează toată povestea? DeepSeek dă totul pe față…

În timp ce multe laboratoare publică doar rezultate, DeepSeek a publicat:

modelul

tehnicile de sparse attention

metodologiile RL

inclusiv cazurile în care modelul eșuează

Asta înseamnă că orice alt laborator poate replica sau îmbunătăți tehnica. Și probabil o vor face în 6–12 luni.

Concluzia: accelerarea competiției dintre laboratoarele chineze și occidentale nu se oprește… se amplifică.

Acces

DeepSeek V3.2 - disponibil acum prin API.

V3.2-Speciale - disponibil temporar până pe 15 decembrie, în timp ce se colectează feedback.

Părerea lui Promptescu

DeepSeek iar a aruncat industria în aer. Sincer, ori au un stoc nelimitat de cafea tare în laborator 😅, ori roboțeii lor chiar nu dorm niciodată. Ce e clar: reușesc de fiecare dată să împingă limitele și să facă restul lumii tech să transpire ușor pe frunte.

Privind la V3.2 și la Speciale, mă încearcă două emoții simultan: entuziasm (că vine viitorul mai repede) și un mic fior (că vine viitorul… mai repede decât eram pregătit). Dar dacă mă întrebi pe mine, competiția asta e exact ce trebuia ca AI-ul să nu doarmă pe vreun munte de bani și promisiuni.

Promptul Zilei: 5 tehnici noi de la OpenAI pentru prompturi mult mai bune

Înainte să intrăm în analiza Codex împreună cu OpenAI, merită să arunci un ochi pe noul lor ghid pentru GPT-5.1-Codex-Max. Printre rânduri, documentația ascunde cinci principii care pot îmbunătăți instant modul în care folosești ChatGPT, Claude sau orice alt model.

1) Înclină balanța spre acțiune

Evită instrucțiunile de tip “înainte, fă un plan”. Modelele tind să se oprească prematur. Mai eficient este:

„Finalizează complet răspunsul, nu doar schița.”

2) Cere mai multe lucruri simultan

În loc de trei întrebări separate, formularea:

„Analizează aceste trei documente împreună și compară temele principale”

produce rezultate mai coerente și mai rapide.

3) Insistă până la capăt

Adaugă propoziția-cheie:

„Livrează munca finalizată, nu recomandări sau următorii pași.”

Elimină jumătățile de măsură.

4) Fii chirurgical de specific

Dacă vrei un anumit stil, spune-l exact:

„Scrie sub formă de raport McKinsey, cu rezumat executiv, trei secțiuni și recomandări bazate pe date.”

Nivelul de claritate = nivelul de calitate.

5) Combate „AI slop-ul”

Ghidul avertizează: instrucțiunile vagi duc la rezultate gen „corporate generic”. Soluția:

„Creează ceva distinctiv și intenționat - evită șabloanele comune.”

De ce contează:

Două cuvinte schimbă tot: distinctiv și intenționat.

Diferența dintre „fă o prezentare” și „fă o prezentare care să nu semene cu un template corporate” e uriașă în practică.

Rundă de finanțare 💰

Honeyjar AI a obținut 2 milioane USD în rundă de pre-seed pentru o platformă AI dedicată comunicării şi PR-ului.

Eikona - un startup din Tel Aviv axat pe marketing personalizat cu AI a atras 5 milioane USD în seed funding.

Black Forest Labs, un startup european de generare de imagini cu AI, a strâns recent o finanțare majoră - ceea ce demonstrează apetitul continuu pentru investiții în capabilități vizuale AI.

Neuronache & Tool-ul Zilei

Aseară m-am băgat iar în subiecte de quantum computing (știu, îmi fac singur rău uneori). După trei paragrafe m-am trezit uitându-mă la un PDF academic care arăta… cum să zic… ca și cum ar fi fost scris pentru extratereștri cu doctorat. Formule peste formule, grafice care păreau glume interne între fizicieni și zero șanse să înțeleg ceva fără să ma doară capul.

Fix atunci am descoperit SciSpace… și pot să zic că mi-a salvat seara. E genul ăla de tool care da la o parte jargonul imposibil și ți-l traduce, pentru oameni reali, nu pentru extraterestri... Îți explică pe bucăți, cu exemple, cu analogii, cu tot ce trebuie ca să nu te simți complet depășit.

Ce este Scispace?

SciSpace este, pe scurt, translatorul tău personal pentru știință și cercetare.

Îi dai un PDF academic, un studiu, un grafic de ți se încrețește sufletul… iar el îl desface în bucăți mici, logice și ușor de digerat.

Este puntea dintre limbajul academic imposibil și explicațiile pe care le poate înțelege un om normal, fără doctorat în astrofizică.

Cu ce te poate ajuta?

Explică articole științifice în limbaj uman

Selectezi un paragraf, o formulă sau un grafic - SciSpace îți spune ce înseamnă, pe înțelesul tău.Îți răspunde la întrebări despre textul din PDF

În loc să scrollezi 20 de pagini, îl întrebi direct:

„Ce vrea să zică autorul aici?” sau „Care e ideea principală?”Clarifică formule și ecuații complicate

Le sparge în concepte simple, cu analogii și exemple.Explică grafice, tabele și diagrame

Nu doar îți traduce ce vezi, ci îți spune și ce înseamnă pentru concluziile studiului.Perfect pentru studenți, cercetători și oameni care învață singuri

Dacă ai deschis vreodată un PDF academic și ai simțit că îți trebuie translator… SciSpace e fix ala.

Verdictul lui Neuronache

În sfârșit… un tool care mă ajută să par inteligent fără să-mi ard ultimii neuroni! Dacă venea SciSpace mai devreme, poate înțelegeam și eu într-o zi cum funcționează entanglement-ul. Până atunci… îl folosesc să supraviețuiesc PDF-urilor… 😄

⏩Pe repede înainte

Dwarkesh Patel este pesimist pe termen scurt… modelele actuale nu învață robust “la locul de muncă” și necesită pre-antrenare scumpă (RLVR), dar extrem de optimist pe termen lung: în 5–10 ani, odată cu adevărata învățare continuă, miliarde de inteligențe artificiale care pot copia și combina cunoștințe ar putea reprezenta AGI în valoare de trilioane.

Evan Armstrong susține că, într-o lume în care LLM-urile fac programarea ieftină, adevărata putere se mută spre companiile marketplace (gen DoorDash), care dețin cererea agregată și pot construi rapid SaaS vertical, hardware și servicii în jurul platformei. Pe scurt: viitorul software-ului = distribuție, nu aplicații izolate.

Martin Alderson argumentează, pe baza datelor, că deși investițiile în datacentere AI pot intra într-o perioadă dificilă dacă adopția de agenți încetinește, nu repetăm criza telecom: eficiența hardware scade, iar cererea pentru workload-uri agentice explodează… ceea ce înseamnă că infrastructura nu va rămâne nefolosită.

CEO-ul IBM, Arvind Krishna, a explicat printr-un “napkin math” că investițiile uriașe în centre de date AI nu au cum să se amortizeze la costurile actuale și estimează șansele ca LLM-urile de azi să ducă la AGI la doar 0–1%.

Asta a fost tot pentru azi!✨

Dacă ți-a plăcut ce ai citit, dă o mână de ajutor echipei Promptescu & Neuronache.

P.S: Până și roboțeii au nevoie de o doza de cofeina :)